Hi ! Day10 !

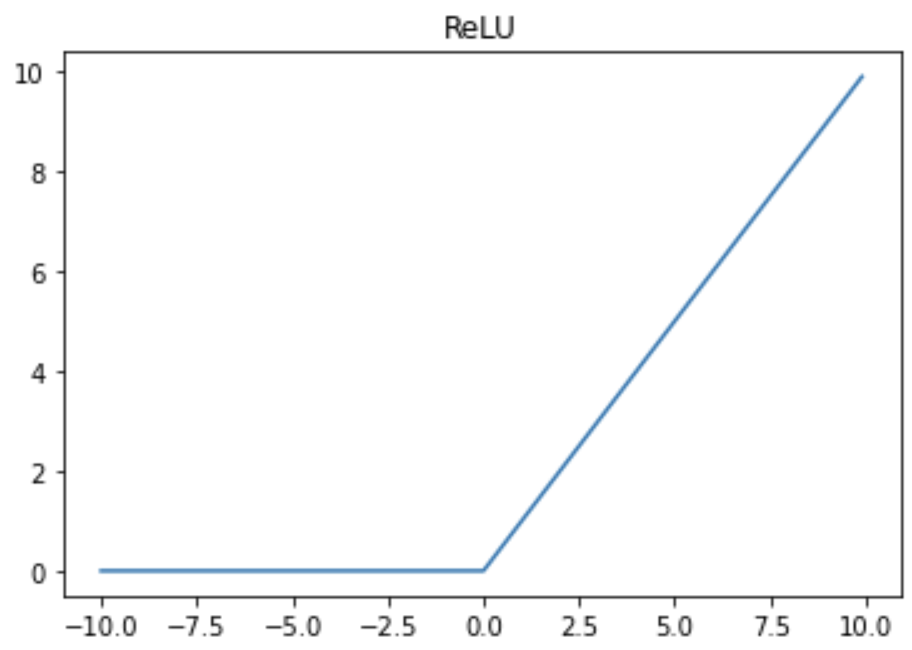

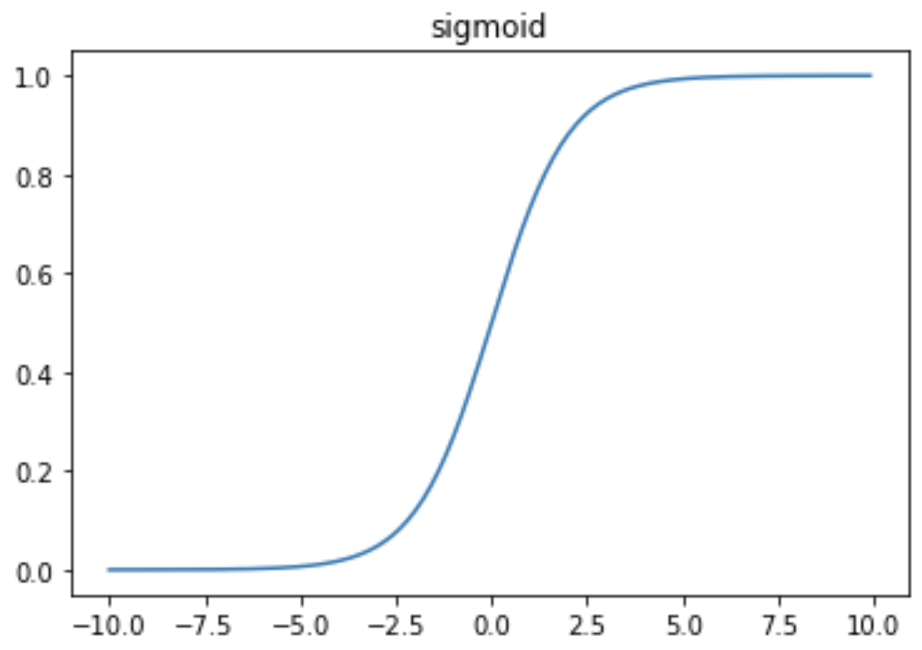

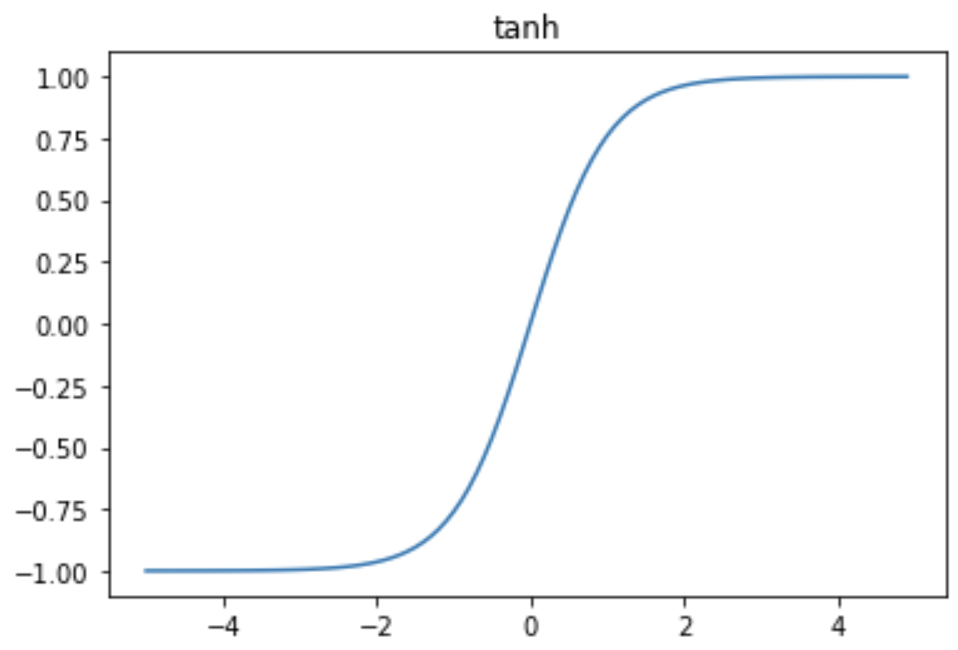

今天要介紹人工神經網路中常用的3個激勵函式:ReLU、sigmoid、tanh

線性整流函式,又稱修正線性單元

S型函數,或稱乙狀函數

雙曲函數

https://www.wpgdadatong.com/tw/blog/detail/42350

https://blog.51cto.com/u_15441799/4718281

https://zh.wikipedia.org/wiki/线性整流函数

https://zh.wikipedia.org/zh-tw/S型函数

https://zh.wikipedia.org/wiki/双曲函数